Robots.txt Nedir?

Robots.txt arama motorlarının sitenizi taraması için belli komutların oluşturulduğu bir komut dosyasıdır. Bu sistemin oluşturulmasının ana nedeni arama motorlarına ait botlara yol göstermektir. Arama motorları sitenizi taramadan önce robots.txt dosyasını incelemektedir. Dosyada izin verilen sayfalarınız için botlar devreye girer ve sitenizin taranma işlemine başlanır.

Robots.txt Dosyasını Tarayabilen Arama Motorları Hangileridir?

Arama motorlarının birçoğu robots.txt dosyasını tarayabilmektedir. Bu arama motorlarından bazıları ise şunlardır; Google, Yandex ve Bing.

Bu arama motorları robots.txt dosyasına rahatlıkla erişebilir ve sitenizle kolayca iletişim kurabilmektedir.

Robots.txt Dosyası Komutları Nelerdir?

- Tarama sonucu ( Gecikme Durumu )

- Dizin eklemesi veya dizinden çıkarma işlemi

- Arama motoru robotunun istediğimiz sayfaları taramasını veya istemediğimiz sayfaları taramamasını yazacağımız komutlar ile belirleyebiliriz.

Robots.txt Dosyası Nasıl Oluşturulmaktadır? Nelere Dikkat edilmelidir?

Dosyayı sitenize eklerken dikkat etmeniz gereken bir kaç önemli kural bulunmaktadır. Bu kurallar dosyayı oluşturmanızın temelini oluşturmaktadır.

Bu kuraldan bazıları ise şu şekildedir;

- Dosyanın adı ‘’robots.txt’’ olmalıdır.

- Dosya sadece sitenizin kök dizinine eklenmelidir.

- Karakter düzenlemesine çok dikkat edilmesi gerekmektedir. Dosyanızı oluştururken karakteri UTF-8 olarak ayarladığınızdan emin olmalısınız.

- Büyük harf ve küçük harflere dikkat etmelisiniz.

Önemli Not: Robots.txt tamamen küçük karakterler ile yazılmalıdır.

Sayfalarınızın adını dosyaya eklerken ise büyük harf ve küçük harf kurallarına dikkat ederek dosyanızı oluşturmalısınız. Örneğin blog sayfanızın B si büyük ise yazarkende bunu belirtmelisiniz, /Blog gibi.

5 – Birden fazla kural giriyorsanız kesinlikle boşluk bırakarak yazmanız gerekmektedir. Karışıklık olması durumun da dizinlerde sorunlar ile karşı karşıya kalabilirsiniz.

6 – Sitenizin protokolü nasıl ise robots.txt dosyası da ona göre yazılmalıdır. Örneğin SSL sertifikanız var ise, HTTPS kullanılarak robots.txt dosyasının oluşturulduğundan emin olun. SSL sertifikanız var ama dosyaya girerken HTTP olarak giriş yaparsanız yine önemli bir sorun ile karşı karşıya kalabilirsiniz ve dilediğiniz değişiklikleri gerçekleştirememiş olabilirsiniz. Bu yüzden robots.txt dosyası oluştururken çok dikkatli olmalı ve en ufak detayları bile kontrol etmelisiniz.

Örnek olarak inceleyecek olursak;

https://www.site.com/ URL den sonra direkt olarak ‘’robots.txt’’ yazılmalıdır.

https://www.site.com/robots.txt

Eğer ki;

https://www.site.com/blog/robots.txt/ böyle bir dosya girişi yapılırsa kesinlikle yanlış bir giriş yapılmış olacaktır. Bu dikkat edilmesi gereken en önemli özelliktir.

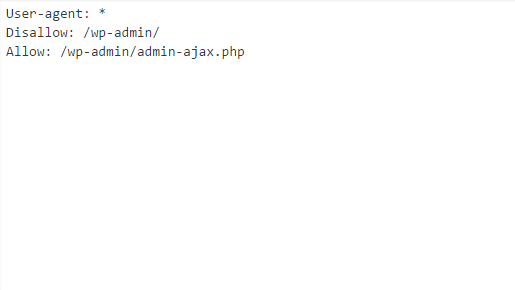

Robots.txt dosyası oluştururken yazılması gereken üç ana komut vardır bu komutlar;

User-agent, Disallow ve Allow komutlarıdır.

User Agent Komutu

Bu komut ile hangi arama motorlarının sitenizi taramasını istediğinizi belirtiyorsunuz. İşlemin yanına * işareti koyarsanız bu tüm tarayıcılar için geçerli olmasını sağlayan bir komut olacaktır.

User-agent: *

Bu komut sitemizin tüm arama motorlarına açık olduğunu göstermektedir.

Sitemiz sadece Google tarafından taransın istersek bunun için kullanmamız gereken komut;

User-agent: Googlebot yazmak yeterli olacaktır.

Disallow Komutu

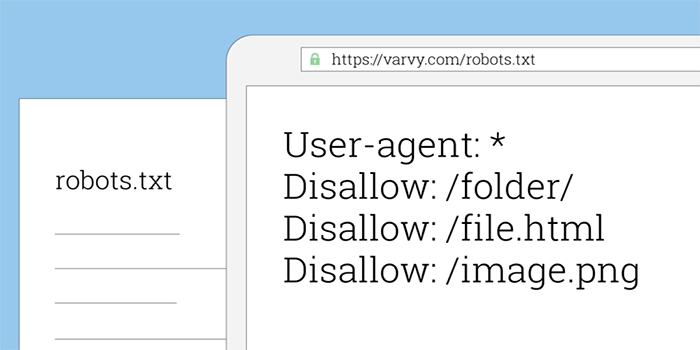

Sitenizin hangi sayfalarının dizine eklenmesini istemiyorsanız disallow komutunu kullanmanız gerekmektedir. Disallow komutunun işleyiş şeklini inceleyecek olursak; Disallow: şeklinde kullanılmaktadır. Sitenizin tüm sayfalarının dizin dışı kalmasını isterseniz; Disallow: / komutunu kullanmanız gerekmetedir. Örneğin sitede belirli bir kısmın dizin dışı kalmasını isterseniz; Disallow: /images/gorsel.jpg şeklinde bir komut girmeniz gerekmektedir. Diğer bir örnek ise, sitenizdeki tüm görsel içeriklerinin gizli kalmasını isterseniz. Disallow: /*.jpg$ komutunu kullanmanız gerekmektedir. Burada $ işareti bir gizleyici, saklayıcı görevini üstlenmektedir. Google bu komutu fark ederek sizin taranmasını istemediğiniz dizinleri taramadan diğer işlemlere geçecektir. Kullanmış olduğunuz sitemap XML altyapısına sahip ise, sitemap: https://www.site.com/ komutunu koyarak bunu belirtebilirsiniz.

Crawl-delay Komutu

Sunucu hatalarında veya geçici süreli bağlantı kesilmesi durumunda kullanılan bir komuttur. Asıl kullanılma amacı ise site tarama süresini belirlememize olanak sağlar. Genel olarak kullanım yerlerine verebileceğimiz örnek; Trendyol, Hepsiburada, N11 olabilir. Çünkü bu komutların kullanılması gereken yerler genellikle ziyaretçi sayısı çok yüksek olan sitelerdir. Tabii ki küçük büyük ayırt etmeksizin genel olarak site için yararlı ise kesinlikle kullanılmalıdır.

Robots.txt Örnekleri ve Çözümleri

Şimdi ise genel bir örnek yapalım ve robots.txt oluşturmayı öğrenelim. Örnek: Sitemiz tüm arama motorlarına açık olsun. Blog yazılarının bazılarında sorun tespit edildi ve index almasını istemiyorsanız izlenecek adımlar şöyle olmalıdır.

User-agent: *

Disallow: /blog/denemeyazisi.html

olarak dizinden çıkarma işlemini kolaylıkla yapabiliriz.

Eğer tüm siteye erişimi engellemek istersek;

User-agent: *

Disallow: /

komutunu kullanmamız yeterli olacaktır.

Gerekli hataları düzelttik o halde disallow edilen işlemi allow olarak tekrar eklememiz gerekmektedir. Bu işlem ise şöyle yapılmalıdır.

Allow: /blog/denemeyazisi.html

Bu işlemler bittikten sonra Google Search Console üzerinden güncellemeleri gerçekleştirmeniz gerekmektedir.

Bu işlemlerin ana yapılma sebebi ise sıralama da kayıplar yaşamamanızdır. Sitenizi tamamen indexe kapatırsanız ve düzenlemeleri öyle gerçekleştirmek isterseniz zamanla sıralamalarda düşmeler başlayabilir, fakat istemediğiniz sayfaları tek tek robots.txt ile arama motorundan çıkarabilir ve gerekli düzeltmeleri gerçekleştirdikten sonra tekrar allow işlemi uygulayabilirsiniz. Zaman kayıpları ve diğer önemli sorunlar yaşamadan işlemleri kolaylıkla çözebilirsiniz.

Robots.txt Dosyasının Doğruluk Testini Nasıl Kontrol Edebiliriz?

Oluşturulan dosyanın doğru olup olmadığını bir kaç site yardımı ile kolaylıkla öğrenebilirsiniz. Bu siteler size sıfırdan robots.txt dosyası oluşturabilir, dilerseniz de sizin oluşturmuş olduğunuz dosyanın doğru olup olmadığını kontrol edebilirsiniz. Robots.txt için bir diğer kontrol sitesi ise, Google Search Console dur. Buradan dosyanın başarılı bir şekilde oluşturulup oluşturulmadığını test edebilmekteyiz.

Robots.txt Dosyasının Google Girişi Nasıl Gerçekleşir?

Google Search Console da robots.txt bölümünden bu işlemi kolaylıkla yapabiliriz.

Sisteme giriş yaptığımızda sağ alt kısımda gönder seçeneğine tıklarsanız karşınıza bir sayfa çıkacak ve buradan dosyanızı görebileceksiniz. Eğer indirmek isterseniz de indir seçeneğine basmanız yeterli olacaktır.

Robots.txt Dosyasında Hata Olup Olmadığı Nasıl Anlaşılır?

Google Search Console ile robots.txt dosyamız da hata olup olmadığını kolaylıkla anlayabiliriz. Robots.txt dosyasının URL ini alarak detaylı bir tarama işlemi gerçekleştirilebilir ve mevcutta hatamız varsa bunları inceleyebiliriz.

Önerilen İçerik: Google Search Console Hataları ve Çözümü

Robots.txt Dosyasının Önemi Nedir? Seo İçin Katkısı Var Mı?

Robots.txt dosyasının sitenizin sıralamasını etkilemesi söz konusu değildir. Robots.txt dosyasının asıl amacı web sitenizin sayfalarının hangisinin taranıp taranmayacağını belli etmektir. Bunlar sıralama ile alakalı olmayan konulardır fakat robots.txt dosyasının doğru bir şekilde oluşturulması ile çok önemli kazançlar sağlayabilirsiniz. Dizine eklemek istemediğiniz bir sayfayı robots.txt aracılığıyla oluşturabilir ve Google’ a sunabilirsiniz. Böylelikle durumunun çok iyi olmadığını düşündüğünüz sayfaları aramadan çıkartarak sitenize önemli bir katkı sağlayabilirsiniz.

İstemediğiniz sayfaları noindex yaparak index almasını engelleyebilirsiniz fakat bu süreç sizin için biraz can sıkıcı olabilir çünkü siz de tahmin edersiniz ki kimi zaman yüzlerde sayfalarla hatta binlerce sayfalarla karşılaşabilmekteyiz. Hatalı gördüğümüz sayfaların hepsini bulup indexe kapatmak ise uzun zamanlarımızı alabilir bunun yerine robots.txt dosyasına istemediğimiz sayfaları eklemek çok daha kolay ve daha hızlı bir çözüm yoludur.

Robots.txt Dosyasına Neden İhtiyaç Duyarız? Site İçin Ne Tür Yararları Vardır?

Robots.txt dosyası ile arama motorlarının olmasını istediği bir site yapısına sahip olabiliriz. Arama motorları kullanıcı deneyimine ve içerik faydasına çok önem vermektedir, oluşturduğumuz dosya ile arama motorlarının botları için işleri kolaylaştırabilir ve arama motorları için iyi bir site örneği olabiliriz. Sitemizi tamamen trafiğe kapatmak yerine sayfa bazlı giderek arama motorlarında sıralama düşmesine engel olabiliriz.

Google’ a dizinlermizi taratmak istersek sadece Google’a özel bir taratma işlemi gerçekleştirebiliriz.

Görünmesini istemediğiniz içeriklerin arama sonuçlarında görünmesini engelleyebilirsiniz. Bunun haricinde ise site haritası hakkında önemli bilgi girişleri gerçekleştirebilirsiniz.

Site haritası hakkında detaylı bilgi almak için Site Haritası Nedir? yazımızdan fayda sağlayabilirsiniz.

Yeni bir site kurulumu yaptıysanız ilk yapmanız gereken şeylerin başında kesinlikle robots.txt dosyası oluşturmak gelmelidir. Eğer çok fazla bilginiz yok ise çeşitli sitelerden faydalanabilir ve sizler için hazırlanan hazır dosya üzerine basit bir iki eklemeler yapabilirsiniz. Hiç bir bilgi olmadan robots.txt dosyası üzerine değişiklikler yapmaktan kaçınmamız gerekir çünkü yapacağınız en ufak yanlış bir düzenleme de bütün sitenizin görünürlüğünü kapatabilir ve siteniz adına büyük zorluklar yaşayabilirsiniz. Büyük sıkıntılar çekmemek ve profesyonel bir hizmet almak için Earnado ile iletişime geçebilirsiniz.